不同肤色的皮肤疾病看起来并不相同,用于培训皮肤科医生的医学教科书和演示文稿通常缺乏深色肤色的示例图像。例如,在最近的大流行期间,研究表明,带注释的 COVID-19 皮肤症状照片缺乏对暗色调的充分表现。

其他研究甚至表明,这种差异可能导致皮肤癌(尤其是所有癌症中转移性最强的黑色素瘤)的诊断对于有色人种来说往往“显着延迟”,以及为什么有色人种的死亡率更高。这些相同的人群。

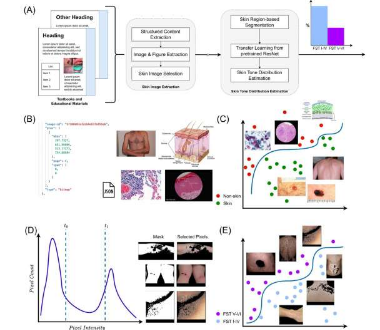

斯坦福大学皮肤科医生和生物医学数据科学家 Roxana Daneshjou 表示:“教材中的不公平就等于社会上的不公平。”Daneshjou 最近与人合作发表在《npj Digital Medicine》上的一项研究,介绍了教育材料中表示的肤色分析 (STAR-ED) 框架,该框架使用机器学习来评估常用医学培训材料中肤色的偏差。

该团队使用医学教科书、讲义、演示幻灯片和期刊文章中的数千张图像对 STAR-ED 进行训练,以确定材料中黑色和棕色皮肤的代表性不足的程度。他们发现,在用于评估肤色的菲茨帕特里克等级中,这些材料中只有十分之一的图像处于黑棕色范围内。

“我们正在稍微扭转人工智能偏见的故事情节,”达内什乔说。“有很多关于人工智能模型存在偏见的新闻,但在这种情况下,我们训练了一个可以检测人类偏见的人工智能模型。”

Daneshjou 承认,STAR-ED 并不是第一个强调这种差异的研究,但它是第一个通过计算机算法使用自动肤色分级的研究,因此比过去的人工标记数据更具可扩展性。Daneshjou 说,人类注释者在判断肤色时很容易疲劳和变化。虽然 STAR-ED 并不完美,但结果与人类注释者的发现非常接近,他们花了很多时间来标记数据。